Andate e fatevi inquietare da ‘Training Humans’, la mostra dell’Osservatorio della Fondazione Prada sull’intelligenza artificiale e sui sistemi di riconoscimento facciale che hanno una storia, un’evoluzione e una sempre maggiore capacità di scannerizzarci e incassellarci…

Il futuro è già qui e non è una buona notizia. Perché ci coglie di sorpresa, come spesso accade, e poco attrezzati a fronteggiare le insidie che la nuova società degli algoritmi ci sta apparecchiando, rubandoci bit dopo bit le nostre identità sociali, economiche, persino fisiche ed emozionali. Non si parla d’altro, tra narrazione e contronarrazione, tra apocalittici visionari e ottimisti pragmatici dell’intelligenza artificiale, ma la realtà corre più veloce della nostra presa di coscienza. Salvo rari squarci. Qualche settimana fa i giovani ribelli di Hong Kong nella loro furia iconoclasta, ma anche per un sano istinto di sopravvivenza, hanno abbattuto le torri-totem dei dispositivi di riconoscimento facciale, che in Cina colonizzano ogni ambito della vita sociale, dalla sicurezza ai consumi. Perché lì ormai la carta di credito è vintage e si paga con la scannerizzazione dei dati biometrici. E se non sei un buon pagatore te lo si legge letteralmente in faccia.

Una bella scossa alla nostra consapevolezza, plasticamente dispiegata nello spazio dell’Osservatorio della Fondazione Prada in Galleria Vittoria Emanuele a Milano, la dà la mostra Training Humans curata da una coppia di artisti-ricercatori: Kate Crawford, australiana, musicista, docente e studiosa delle implicazioni etiche dell’Ai in diverse università del mondo, e Trevor Paglen, artista americano da anni impregnato in un progetto sulla società della sorveglianza di massa. Più che una mostra è un catalogo di tutto ciò che è stato fatto negli ultimi sessant’anni nel campo del riconoscimento facciale e del machine learning, l’addestramento dell’intelligenza artificiale a classificare e riconoscere le persone. Il lavoro dei due artisti è stato innanzitutto quello di raccogliere migliaia di immagini, la maggior parte delle quali archiviate in database non destinati alla pubblicazione e finalizzate a elaborare sistemi di riconoscimento biometrico. A partire dal Facial Recognition Project Report, realizzato dalla Cia nel 1963, che classifica migliaia di foto di volti per estrapolare pattern, a cui seguono video di crudelissimi esperimenti su gattini condotti nel 1973 per progettare la computer vision. Video e fotografie esposti mostrano l’acquisizione di scansioni di volti, impronte digitali, stili di camminata, impronte vocali. Su una parete sono appese le sequenze di foto segnaletiche di criminali più volte arrestati nel corso della loro vita, elaborate per istruire un sistema di riconoscimento facciale che calcoli l’invecchiamento e conservate nel National Institute of Standard americano, quello che appunto certifica gli standard e le unità di misura.

(I curatori Kate Crawford e Trevor Paglen)

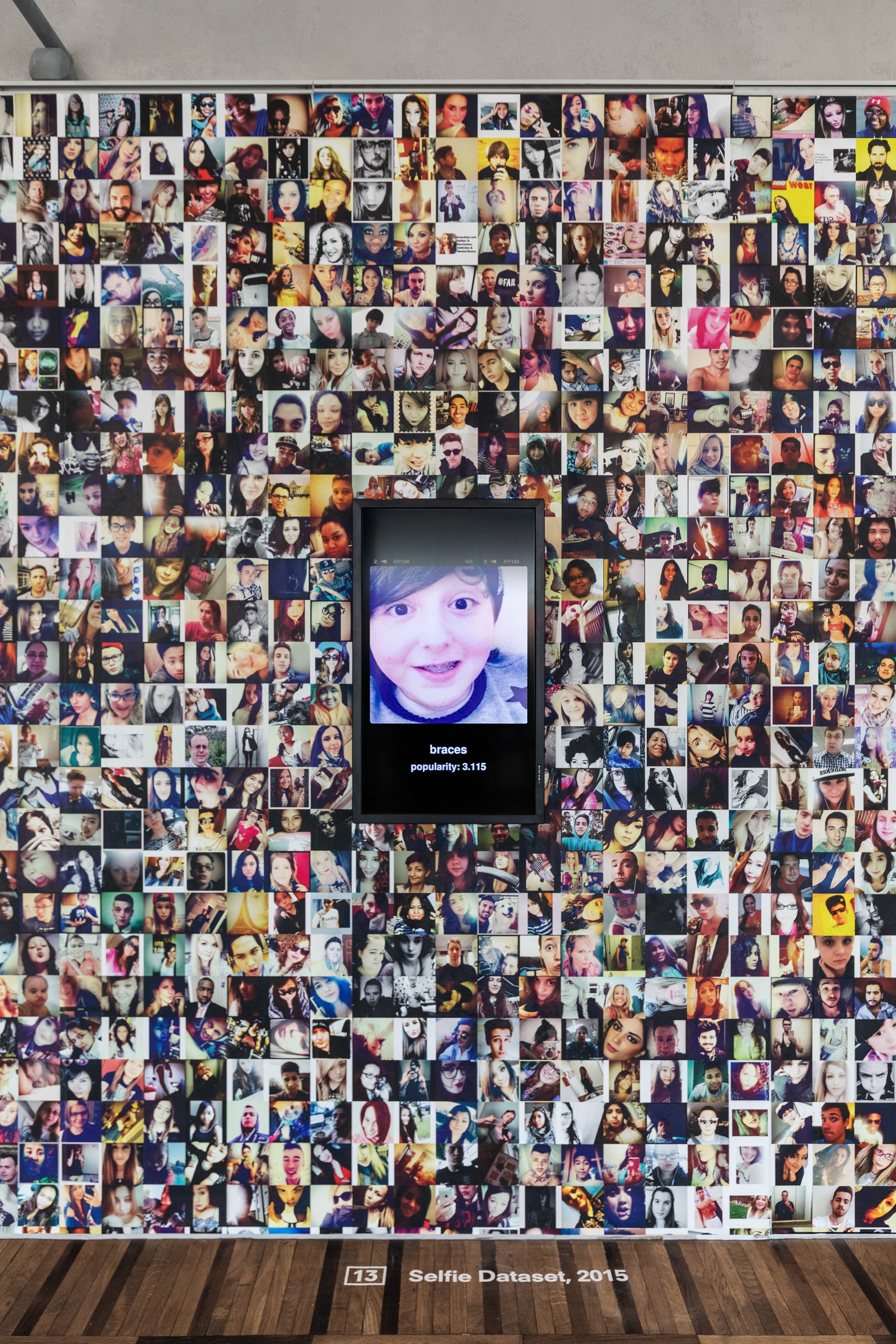

Ma la vera svolta, il cambio di paradigma quantitativo e qualitativo che rende concreto l’incubo totalitario della sorveglianza globale e trasforma la parola privacy in un grido rivoluzionario, arriva con internet, quando il problema non è più raccogliere il materiale, ma catalogarlo e ordinarlo con sistemi sempre più sofisticati e opinabili, perché il materiale, miliardi e miliardi di immagini, lo forniamo noi spontaneamente e per lo più inconsapevolmente attraverso Instagram, Facebook e tutti gli altri social. In questo millennio le opzioni di classificazione si moltiplicano in modo esponenziale e con esse i dilemmi etici, che per ora la rincorsa tecnologica sembra demolire come un caterpillar. Due ricercatori dell’Università del Tennessee hanno realizzato un set di 20 mila volti per classificare gli individui in base a sesso, genere ed età. I criteri utilizzati sono binario per il genere maschio/femmina, con tanti saluti alle sfumature Lgbt, e le razze sono cinque: bianco, nero, asiatico, indiano e “altri” grazie ad una certo schematismo neocoloniale. Il “Selfie dataset” dell’università della Florida invece contiene 40 mila fotografie raccolte su Instagram e suddivise in base a età, sesso, razza, forma del volto, espressione, taglio di capelli, accessori. Impressionante il progetto Image-net dell’università di Princeton e Stanford, una specie di allucinazione borgesiana che aspira a mappare l’intero universo degli oggetti e che per ora raccoglie più di 14 milioni di immagini suddivise in 21.841 categorie tra cui cose, animali, piante ecc. Un milione sono le immagini di persone, classificate in base a 2000 tipologie, anche di tipo comportamentale ed emotivo, di cui migliaia esposte nella mostra. E così la didascalia di un’immagine di Hilary Clinton è “virago” e due ragazzine che sorridono sono “neutral”, persone che non prendono posizione, mentre Chavez un “autoritario”. Diversi i progetti in mostra per classificare le espressioni e le emozioni, lo stato di salute mentale, fino ai sofisticati modelli sviluppati dai ricercatori di Facebook e Amazon per stimare l’età, il sesso e la condizione emotiva dei volti che rileva in rete.

Come sottolinea Kate Crawford, il grande inganno è la cosiddetta “Fake Automation”, ossia l’idea che l’algoritmo ci metta al riparo dalle sporcizie degli stereotipi, quando la realtà è che spesso dietro a complicati processi di catalogazione «ci sono centinaia di omini sottopagati in qualche garage indiano o cinese che classificano le immagini vittime delle loro credenze» sulla base delle indicazioni, e le credenze, di qualche committente wasp che risiede nella Silicon Valley. L’algoritmo non è mai neutro, ma si nutre dei nostri pregiudizi, dei pregiudizi di chi lo progetta, amplificandoli in proporzioni che sfuggono al nostro controllo.

Il dibattito è aperto e bollente. Molto si è scritto sui pregiudizi razziali o sessisti. Caso di scuola è quello verificato nel 2015 in uno studio dell’università di Washington: effettuando la ricerca su Google immagini della parola “amministratore delegato” (Ceo, in inglese è neutro) solo l’11% erano foto di amministratrici delegate in un momento, il 2015, in cui nella realtà le donne ai vertici erano il 27%. Ma l’affare si complica ulteriormente se questi data base valutano anche risvolti più sottili, attraverso la codificazione di emozioni, riducendo a pattern la complessità della natura umana. Vi piacerebbe essere selezionati per un lavoro in base al giudizio di un algoritmo sull’espressione e i tratti che avete nella foto del curriculum o su Facebook? No, probabilmente, ma la notizia è che sta già succedendo. Speriamo con sistemi più precisi di quelli allestiti all’Osservatorio di Prada, dove ci si può sottoporre ad una telecamera intelligente, che nel caso di chi scrive, giornalista matura, ha dato come risultato: maschio tra i 25 e i 32 anni, stato emotivo: disgusto.

TRAINING HUMANS

Fino al 24 febbraio 2020

Fondazione Prada Osservatorio

Galleria Vittorio Emanuele II, Milano

Foto, courtesy Osservatorio Fondazione Prada